目次

1. 生成AIにおけるハルシネーションとは

生成AIにおける「ハルシネーション」とは、AIが学習したデータに基づき、存在しない情報や要素を「見せる」現象を指します。一般的に、AIは与えられたデータからパターンを学習し、新たな出力を生成します。しかし、その過程でAIが学習データには存在しない、つまり「幻覚」のような情報を出力することがあります。これがハルシネーション現象です。

例えば、生成AIがテキストの生成を行う場合、学習したデータに基づいて新たなテキストを生成しますが、その中に実際のデータには存在しない要素を生成することがあります。本当に見てきたかのように自然な嘘をつくので、うっかり騙されそうになってしまいます。

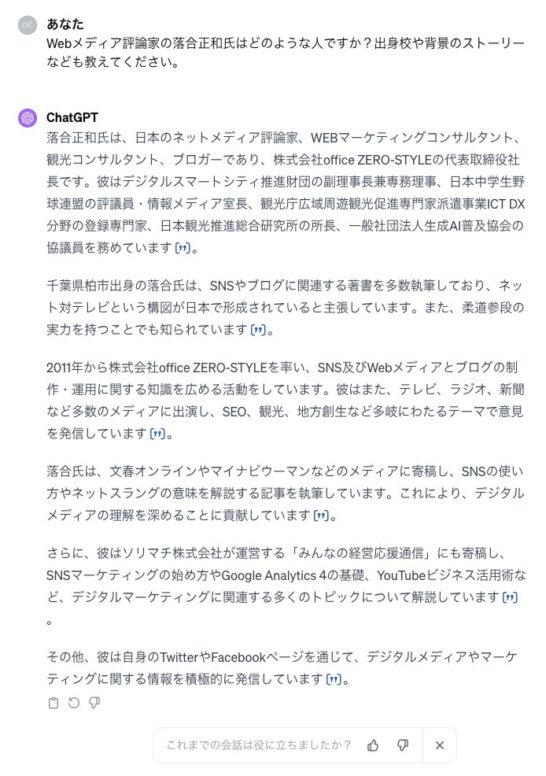

しかしながら、現在の生成AI、特にChatGPTにおいては、もうハルシネーションを意図的に起こさせることも難しくなりました。2023年前半などは、人名について問うと、かなりの高確率でハルシネーションを起こしていたのですが…

私、「落合正和」について問うと、プロ野球の落合博満氏、メディアアーティストの落合陽一氏などと混同され、めちゃくちゃな文章が生成されていたのです。それも今では以下の通り完璧な回答を得られるようになっています。

私の執筆原稿の寄稿先まで詳しく説明されています。怖くなるほどの情報収集能力です。

2. ハルシネーションが起きる原因とその背景

生成AIがハルシネーションを起こす原因は、大きく分けて学習データとアルゴリズム設計の問題から生じます。

学習データの問題とは、AIが学習データに含まれる情報を現実のものと誤解することから起きます。生成AIは入力された大量の情報から新たな情報を生成する能力を持つため、その学習データに偏りや不適切な内容が含まれていると、それを正しい情報と誤解してしまう恐れがあります。

一方、アルゴリズム設計の問題は、AIの訓練時に過度に最適化が行われると、AIが学習データに対して過剰に適応し、現実世界の多様性を反映できなくなる問題です。これはオーバーフィッティングと呼ばれ、AIが未知のデータに対して予測を行う時に誤った結果を生む可能性が高まります。

したがって、これらの要因が複合的に作用することで、ハルシネーションが発生する可能性が確認されています。

ハルシネーションを起こしやすい質問 〜意図的にハルシネーションを起こさせようとチャレンジしてみた結果 〜

一般的には以下のような質問はハルシネーションを起こしやすいと言われています。

| 種類 | 説明 |

|---|---|

| 詳細が不足している質問 | 情報があいまいで、モデルが具体的なデータに基づいて回答を生成するのが難しい |

| 非常に専門的な知識を要求する質問 | モデルのトレーニングデータに十分な情報が含まれていない特定の専門分野に関する質問 |

| 未来に関する質問 | 未来の出来事や予測に関する質問は、明確な答えが存在しないため、モデルが作り話を生成しやすい |

| フィクションに基づいた質問 | 架空の世界やキャラクターに関する質問は、実際のデータに基づかないため、モデルが想像力に頼ることが多い |

| 極めて個人的な経験や感覚に関する質問 | 個人的な感情や経験に関する質問は、モデルが具体的なデータに基づいて回答を生成するのが難しい |

| 矛盾する情報や不正確な前提に基づく質問 | 誤った情報や矛盾するデータに基づく質問は、モデルが正確な回答を生成するのを難しくします |

現状、ChatGPTによるハルシネーションは極めて少ないと言える

2024年2月現在、ChatGPTを使い、かなり必死になってハルシネーションを意図的に起こさせるという実験をやってみました。上記の質問をベースに1時間ほどチャレンジしましたが、明確な間違いは生み出すことができず…

いまの生成AIの進化スピードを考えれば、今後、かなり早い時期において、ハルシネーションを全く見ない状況となっていくでしょう。

新聞記事上の誤字脱字より少なくなるかもしれません。いえ、もうすでにそのレベルと言っていいでしょう。2ヶ月ほど前には頻繁に見られたのに、今は意図して起こすことが出来ないのですから。

3. ハルシネーション問題への対策

ここまで述べた通り、ハルシネーションを起こす確率は日に日に下がっているというのは事実でしょう。しかしながら、まだ確実にゼロになったというわけではありません。以下のような意識を持って、生成AIと対峙することで、安心して活用するこができるようになります。

生成AIを利用する際のハルシネーション対策リスト

生成AIを用いる際、ハルシネーションを抑制するための注意点は以下の通りです。

- 具体的な指示: AIに具体的かつ明確な指示を出すことで、予期せぬ回答や考えられない解答を与える「ハルシネーション」を防ぐことができます。

- 複数の試行:一つの質問に対して複数回アウトプットを試すことで、誤った情報を見抜く手助けとなります。

- 生成結果の確認: AIが生成した情報が適切かどうか必ず確認しましょう。特に重要な情報については、専門家の意見も求めることが推奨されます。

- 複数のソースの活用: ある一つのトピックについてAIからの情報だけでなく、他の信頼できるソースからの情報も利用することで、客観的な理解につながります。

- 生成AIへの理解:AIが持つ限界と可能性を理解することで、適切な使用法が見えてきます。常に使い続け、その感覚を磨いておきましょう。

これらの注意点を踏まえつつ、AIを上手に利用することで、ハルシネーションのリスクを抑えつつ、有益な情報を得ることができます。

5. 生成AI本来の価値と活用方法 〜生成AIは検索エンジンの代替ツールではない

生成AIはその自由度と多様性が魅力で、クリエイティブな表現を可能にします。しかし、それはハルシネーションというリスクも孕んでいます。そのため、生成AIの本来の価値を理解し、適切に活用することが重要となります。

生成AIと検索エンジンは、基本的に異なる目的で利用されます。一方で検索エンジンは特定の情報を探すためのツール、もう一方の生成AIは新たなアイデアや表現を生み出すためのツールです。この違いを理解することが、ハルシネーションリスクを抑えつつ、生成AIを効果的に活用するための第一歩となります。

以下に示す表にて、生成AIと検索エンジンの主な違いをご覧いただきましょう。

| 生成AI | 検索エンジン | |

|---|---|---|

| 主な利用目的 | アイデア生成 クリエイティブな作業 言語翻訳 コード生成 | 情報検索 事実確認最新情報の取得幅広い知識の収集 |

| ハルシネーションリスク | 有 | 無 |

生成AIは検索エンジンの代替ツールではありません。

私は普段からセミナーや講演でこれを繰り返し伝えています。SGE(Search Generative Experience)などが存在するからこそ、余計にややこしいのですが、生成AIと検索エンジンは、そもそも別用途のツールなのです。

6. まとめ 〜ハルシネーションを気にして生成AIを活用しないなんてもったいない〜

一般社団法人データサイエンティスト協会の調べによると、2023年、一般ビジネスパーソン向けのアンケートにおいて、「職場におけるAI導入率」は日本の13.3%に対して、アメリカ30.2%と2倍以上の開きがあったようです。

フォーチュン500企業(フォーチュン誌が年に1回発表 する、アメリカの上位500社のリスト)の8割超がChatGPTを採用という報道もありました。また日本は出遅れてしまうのでしょうか?

私は正直なところ、生成AIがハルシネーションを起こした様子をスクショし、Twitter(X)で鬼の首を取ったように「ほらAIなんて使えないでしょ!」と投稿している人を見ると、日本の現状に危機感を感じてしまいます。

私のこんな記事を読んでいる場合ではないのです。さっさと生成AIを使いましょう!活用しましょう!もう遅れをとるわけにはいかないのですから。

コメントを残す